La espada de doble filo: el código generado por IA en el sector bancario

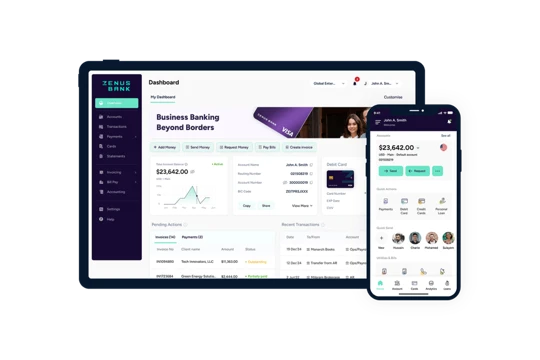

Pedro Martinez, CIO & CISO at Zenus Bank

Technology

El actual auge de la Inteligencia Artificial (IA) ha tenido un profundo impacto en el sector bancario y en la tecnología financiera, ya que ofrece la posibilidad de aumentar la eficiencia, mejorar el servicio al cliente y mejorar la gestión de riesgos. Sin embargo, a medida que nos subimos a esta ola de transformación tecnológica, surgen importantes cuestiones relativas a las vulnerabilidades de seguridad, la propiedad del código y los derechos de autor de las aplicaciones asociadas al código generado por IA. Este artículo pretende diseccionar estas cuestiones, situándolas en un contexto histórico y ofreciendo un camino a seguir a los ejecutivos bancarios que navegan por este complejo panorama.

Históricamente, la adopción de la IA por parte de los principales bancos estadounidenses ha sido lenta, pero empezó a acelerarse a mediados de la década de 2010. Las tecnologías avanzadas de IA se emplearon inicialmente para agilizar el servicio al cliente a través de chatbots, antes de evolucionar gradualmente para gestionar tareas más complejas, como la detección de fraudes, la calificación crediticia y la evaluación de riesgos. En la actualidad, plataformas de IA como GPT de OpenAI, Watson de IBM, Azure de Microsoft y DeepMind de Google, forman parte del funcionamiento de muchas entidades financieras.

Sin embargo, como ocurre con cualquier tecnología transformadora, la IA trae consigo un nuevo conjunto de retos. Uno de ellos es que el código generado por IA que puede introducir vulnerabilidades de seguridad. El desarrollo tradicional de software implica la supervisión humana en cada etapa, garantizando que cada línea de código se adhiera a los protocolos de seguridad establecidos. Sin embargo, con el código generado por IA, esta supervisión se hace cada vez más difícil. Si no se detectan, estas vulnerabilidades podrían exponer datos sensibles de los clientes, lo que podría dar lugar a brechas de seguridad a gran escala. Esto plantea la necesidad de sistemas avanzados de verificación del código y de un mayor escrutinio normativo.

Además de las vulnerabilidades de seguridad, el tema de la propiedad del código se ha convertido en una cuestión pertinente. Si una IA, como la GPT de OpenAI, ayuda a escribir una aplicación, ¿sigue perteneciendo al programador original? La Oficina de Patentes y la Oficina de Derechos de Autor de Estados Unidos no ofrecen actualmente ninguna orientación definitiva sobre esta cuestión. En las situaciones tradicionales, el código pertenece al programador humano que lo escribió. En cambio, el código generado por IA difumina estas líneas, lo que lo convierte en una cuestión apremiante que debe ser abordada por los legisladores y los organismos reguladores.

Además, la aplicación de las leyes de derechos de autor al código generado por IA es igualmente nebulosa. Según la legislación estadounidense vigente, la protección de los derechos de autor sólo se extiende a las obras originales. Dado que la IA carece de personalidad jurídica, no puede ser titular de derechos de autor. Sin embargo, la creciente prevalencia de la IA en la generación de contenidos enturbia las aguas. ¿Las obras creadas con una contribución significativa de la IA se consideran obras originales de autoría humana o un producto de la IA? Esta cuestión aún está por resolver.

Las amenazas a la seguridad

A medida que la IA penetra en el sector bancario, también abre nuevas vías para los agentes maliciosos. Las posibles amenazas a la seguridad van desde la sutil usurpación de identidad hasta las graves violaciones de datos.

Una de las principales preocupaciones es el uso de la IA por parte de los ciberdelincuentes para el robo de identidad, especialmente durante el proceso de incorporación. Aprovechando la tecnología de deep-fake -una sofisticada aplicación de IA que puede manipular o fabricar contenido visual y de audio-, los estafadores pueden ahora falsificar identidades de forma convincente. Por ejemplo, en 2021, una persona de Nueva Jersey fue acusado de utilizar IA para crear identidades sintéticas y estafar a los bancos por cientos de miles de dólares.

Las vulnerabilidades del código generado por IA también suponen un riesgo importante. La IA, en particular los modelos de aprendizaje automático, son vulnerables a ataques de adversarios que manipulan los datos de entrada para engañar al modelo, lo que conduce a resultados erróneos. Un adversario podría, por ejemplo, explotar esta vulnerabilidad para engañar a un sistema de detección de fraudes y aprobar transacciones fraudulentas.

También existe la amenaza del envenenamiento de datos, en el que un atacante inserta datos maliciosos en el conjunto de entrenamiento para sesgar el proceso de aprendizaje del sistema de IA. En un escenario bancario, esto podría comprometer un modelo de evaluación de riesgos, provocando pérdidas financieras.

Como respuesta, el sector no sólo debe estar al tanto de estas amenazas, sino también invertir en el desarrollo de sistemas de IA que sean resistentes a este tipo de ataques. La realización de pruebas rigurosas, la supervisión continua y el uso de medidas de cifrado y ciberseguridad de última generación pueden ayudar a los bancos a proteger sus sistemas de IA frente a estas amenazas.

Impacto económico y normativo de las amenazas a la seguridad de la IA

Las amenazas a la seguridad que plantea la IA tienen repercusiones económicas y normativas directas e indirectas en el sector bancario. Pueden conducir a pérdidas financieras significativas, daños a la reputación, sanciones regulatorias y un mayor costo de las operaciones.

En 2022, un sofisticado ciberataque dirigido por IA contra un banco estadounidense dio lugar a transferencias no autorizadas por un valor de un millón de dólares. Este ataque utilizó una forma de manipulación de IA conocida como "evasión de modelos", que modificó los datos transaccionales de una manera que evadió el sistema de detección de fraudes del banco. El ataque provocó importantes pérdidas financieras y un mayor escrutinio por parte de los reguladores.

Otro ejemplo es un caso de 2023 en el que una importante empresa de tarjetas de crédito sufrió una violación de datos a gran escala debido a una vulnerabilidad no detectada en su chatbot de atención al cliente impulsado por IA. La brecha expuso los datos personales de millones de clientes, lo que dio lugar a demandas colectivas, sanciones reglamentarias y un importante daño a la reputación.

Los costos de estos incidentes van más allá de las pérdidas financieras inmediatas. Los bancos se enfrentan a mayores gastos para mejorar sus medidas de ciberseguridad, contratar personal calificado y garantizar el cumplimiento de la normativa. Tras estos incidentes, los bancos suelen experimentar mayores tasas de pérdida de clientes y una menor confianza de los accionistas, lo que puede afectar a la rentabilidad a largo plazo.

En el plano normativo, estas violaciones de la seguridad suelen atraer la atención de organismos reguladores como la Reserva Federal y la Oficina del Interventor de la Moneda (OCC) de Estados Unidos. Estas instituciones pueden imponer sanciones, aumentar el rigor de los estudios reglamentarios y exigir prácticas de gestión de riesgos más estrictas.

En respuesta a la mencionada filtración de datos de las empresas de tarjetas de crédito, la OCC aumentó su escrutinio de las implementaciones de IA en todo el sector bancario y publicó nuevas directrices sobre la seguridad de la IA. Esta acción reguladora ha aumentado la carga de cumplimiento de los bancos y otras instituciones financieras, lo que los ha llevado a reevaluar sus estrategias de adopción de IA y sus prácticas de gestión de riesgos.

Mirando el lado positivo

A pesar de estos retos, es fundamental recordar que la IA es una herramienta que puede aprovecharse de forma segura con las medidas adecuadas. Por ejemplo, para hacer frente a las vulnerabilidades de seguridad, las instituciones bancarias pueden aplicar prácticas sólidas de revisión y comprobación del código, invertir en tecnologías avanzadas de ciberseguridad y actualizar periódicamente sus protocolos de seguridad. En cuanto a la propiedad del código y los derechos de autor, unas directrices y acuerdos claros previos a la utilización de la IA pueden proporcionar cierta protección hasta que se establezcan normas legales formales.

Desde una perspectiva más amplia, los beneficios potenciales de la IA en el sector bancario superan con creces los riesgos, especialmente cuando estos se mitigan adecuadamente. La IA permite una toma de decisiones más rápida y precisa, reduce drásticamente los costes operativos y mejora significativamente la experiencia del cliente. Además, la capacidad de aprendizaje y adaptación de la IA puede ayudar a los bancos a mantenerse a la vanguardia frente a amenazas financieras en constante evolución.

Teniendo todo esto en cuenta, aunque la integración de la IA en el sector bancario y de las tecnologías financieras aporta innegables beneficios, también plantea una nueva serie de retos en materia de seguridad, propiedad del código y derechos de autor de las aplicaciones. A medida que avanzamos, estas cuestiones deben abordarse cuidadosamente, con un enfoque equilibrado que reconozca el potencial de la IA, pero sin perder de vista los riesgos asociados. En última instancia, la clave está en sortear estos retos estratégicamente para liberar todo el potencial de la IA, impulsar la innovación y transformar el futuro de la banca.